SipXcom 4.4 / 4.6 Virtualisierung im Test

Testbeschreibung

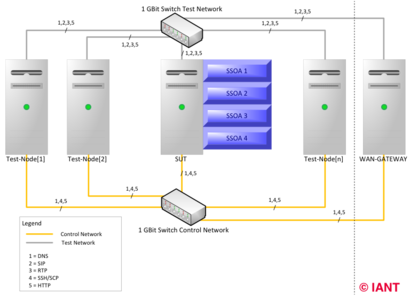

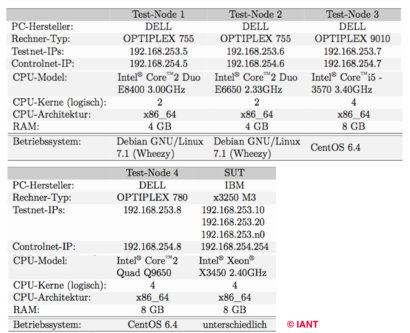

Als System under Test (SUT) kommen zwei verschiedene SSOA-Implementationen zum Einsatz, SipXecs 4.4 und 4.6. Beide Systeme werden zunächst direkt auf der Hardware und anschließend als virtuelle Maschine (VM) mit einem ESXi 5.1 Hypervisor ausgeführt. Beim Test der SSOA als VM ist diese die einzige ausgeführte VM auf der Virtualisierungslösung. Die Klärung der grundsätzliche Effekte von Virtualisierung auf Unified Communications-(UC)- Umgebungen wird nur durch einen direkte Vergleich zwischen einem physisch und einem virtuell laufenden System mit den selben Hardwareressourcen möglich.

Getestet wird mit jedem der SUTs zum Einen die Skalierbarkeit der Zeichengabe- Dienste und zum Anderen die generellen Qualitätsparameter (Jitter, Packet- loss, …) bei der Erbringung der Nutzdatendienste. Der Aufbau der SSOA erlaubt die Trennung von Signalisierung und Nutzdaten, wodurch auch die Testfälle unabhängige betrachtet werden können.

- Registrierungen (SIP-REGISTER)

- De-Registrierungen (SIP-REGISTER mit Expire-Time: 0)• Re-Registrierungen (SIP-REGISTER mit Expire-Time >0)

- UAC/UAS (SIP-INVITE, SIP-BYE zwischen zwei Test-Nodes; Simulation eines Voice-Calls (Signalisierung))

- MessageC/MessageS (SIP-MESSAGE zwischen zwei Test-Nodes)

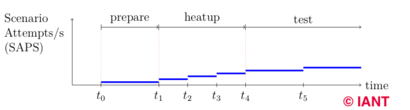

Die Test Szenarien sind in folgendem Diagramm zu sehen.

In der Abbildung sind verschiedene Phasen zu sehen. In den Phasen werden die SAPS immer weiter erhöht. Im Bereich zwischen t0 und t1 ist eine Vor- bereitungsphase zu sehen (prepare), in der ein Grundstamm von Testnutzern registriert wird. Dies ist notwendig, um einen Pool an Nutzern zu haben an den INVITEs gesendet werden können.

Der Bereich von t1 bis t4 bildet eine Aufwärmphase (heatup) für das SUT. Diese Aufwärmphase dient der langsamen Erhöhung der Last auf das System um dieses zunächst auf Betriebstemperatur zu bringen. Diese Zeitraum ist selbst in drei Phasen unterteilt, bei der die Last schrittweise erhöht wird.

Ab t4 beginnt der eigentliche Testlauf. Die Phasen sind länger und die Last wird weiter erhöht. Am Ende jedes Testschrittes wird geprüft ob die Fehlerrate über dem zulässigen Wert liegt. Ist dies nicht der Fall, werden die SAPS erhöht und der nächste Testschritt bis zum Ende durchlaufen. Erst dann wird erneut geprüft. Die Fehlerrate ist als prozentualer Wert vom betrachteten Zeitraum abhängig. Eine zu Beginn als 100% gemessene Fehlerrate kann sich über die Laufzeit einer Testphase noch in den Promille Bereich verschieben. Dies wäre beispielsweise der Fall, wenn nur das erste Szenario fehlschlägt und anschlie- ßend kein weiteres.

Testergebnisse von den Zeichengabe-Dienste

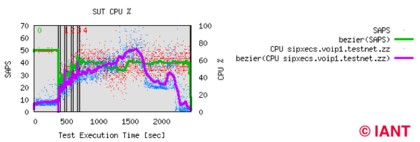

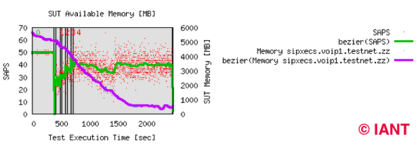

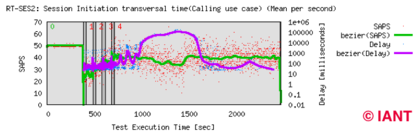

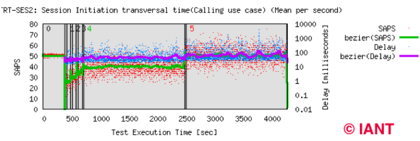

Testergebnisse bei einem Testlauf mit einem virtuell laufenden SipXecs 4.4 als SUT. SAPS (Scenario Attempts Per Second).

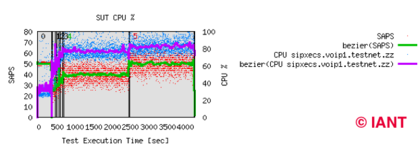

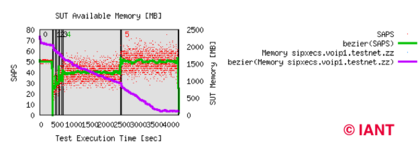

Testergebnisse bei einem Testlauf mit einem virtuell laufenden SipXecs 4.6 als SUT. SAPS (Scenario Attempts Per Second).

Gesamtauswertung

Über SIP/VoIP

- Session Initiation Protocol

- SIP Protokoll im Detail

- Was ist SSOA?

- VoIP Telefonanlagen

- Was ist SIP B2BUA

- Was ist ein SBC?

- SIP Proxy und B2BUA Architektur

- SIP-Trunking

- Das BLF Besetztlampenfeld

- Was ist ACD?

- WebRTC

- WebRTC VoIP Softphone

- SIP over WebSockets

- REST-Schnittstelle

- SOAP-Schnittstelle

- VoIP und SIP Sicherheit

- QoS in VoIP Netzwerken

- Fax over IP

- SDN und VoIP

- ISDN-Abkündigung

SipXcom und VoIP-Telefonanlagen

- VoIP Telefonanlagen

- IANT VoIP Telefonanlagen auf Basis von SipXcom bzw. Uniteme

- SipXcom Virtualisierung

- SipXcom Virtualisierung im Test

- SipXcom Virtualisierung im Test – Mediendienst

- SipXcom / openUC als private Cloud Service anbieten

- Hochverfügbarkeit (HA) Mechanismen bei SipXcom / openUC

- Vendor Lock-in in der VoIP Welt

- Das Voicemail-system

- IP Telefon Autoprovisionierung durch SipXcom

- Konfiguration SipXecs RESTful Dienst

- ACD Lösung basiert auf Askozia (In-house Call Center)

- SOAP

- Die Neuheiten von SipXecs Version 4.6

- FMC

- SipX im Praxiseinsatz

- Unified Communications

- Computer Telephony Integration

- Interactive Voice Response

- SIP Endgeräte

- IP-Telefonie und die europäische Datenschutz-Grundverordnung DS-GVO

- Sanft migrieren